구글 TPU 외부 공급 전환 본격화…메타 협상 논의와 엔비디아 중심 AI 칩 생태계의 균열

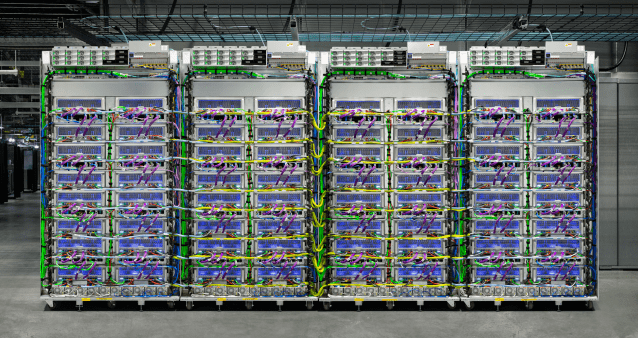

구글 TPU가 클라우드 한정 모델에서 벗어나 고객사 데이터센터 직접 설치 방안까지 검토되면서 AI 인프라 판도가 재편되는 국면에 접어들었습니다.

업계는 메타와의 수십억 달러 규모 협상 논의 보도를 주목하며, 엔비디아 중심의 AI 칩 시장에 구조적 변화가 시작됐다고 평가합니다.

구글 TPU(Tensor Processing Unit)는 대규모 행렬 연산에 최적화된 AI 전용 가속기로서, 학습과 추론 모두에서 XLA 컴파일러와 결합해 높은 효율을 제공합니다.

그간 구글 클라우드 내부에서 주로 제공되던 TPU가 외부 고객 데이터센터로 확대될 경우, LLM 학습과 대규모 추론 파이프라인의 총소유비용(TCO) 구조가 달라질 가능성이 큽니다.

해외 매체들은 "메타가 자사 데이터센터에 구글 TPU를 도입하는 방안을 논의 중"이라고 전하며, 단기적으로는 클라우드 임대, 중장기적으로는 온프레미스 설치 시나리오가 거론된다고 보도했습니다※ 외신 종합.

이는 공급 제약과 가격 협상력이 집중된 GPU 일극 체제에 대한 리스크 헤지로 읽히며, 빅테크의 멀티가속기 전략을 가속할 변수로 해석됩니다.

일부 매체는 ‘블랙웰 넘은 TPU…구글, 왕의 귀환’이라는 과감한 헤드라인을 내며 성능-비용 지형 변화를 강조했습니다.

동시에 브로드컴은 2016년부터 구글 TPU와 동행해온 파트너로 주목받으며, 관련 생태계 수혜 기대가 커지고 있습니다.

아마존, 메타, 앤트로픽 등 하이퍼스케일러의 멀티벤더 전략 확산은 인터커넥트, 패키징, 고대역폭 메모리(HBM)까지 연쇄적으로 파급될 전망입니다.

TPU가 주목받는 이유: 성능 효율, 소프트웨어 스택, 보안

구글 TPU는 행렬 연산 전용 아키텍처와 XLA 기반 컴파일 최적화로, LLM 학습과 대규모 추론에서 와트당 성능과 총비용 효율을 높이는 데 특화되어 있습니다.

자체 칩과 네트워킹, 컴파일러, 프레임워크 스택이 수직 통합되어 있어 지연 시간, 에너지, 랙 밀도 관점에서 시스템적 이점을 제공합니다.

소프트웨어 측면에서는 TensorFlow, JAX, PyTorch/XLA 지원이 핵심이며, 최근에는 LLM 파인튜닝과 MoEMixture-of-Experts 워크로드에서 분산 스케일을 유연하게 구현하는 사례가 늘고 있습니다.

보안과 데이터 거버넌스 요구가 높은 기업은 온프레미스형 TPU 또는 전용 리전 구성을 통해 규제 준수를 강화할 수 있다는 점도 장점으로 거론됩니다.

엔비디아-AMD-GPU 진영과의 비교 관점

엔비디아는 생태계 완결성과 광범위한 프레임워크 호환성에서 우위를 갖추고 있으며, 대형 모델 학습에서의 최적화 레퍼런스가 풍부합니다.

반면 구글 TPU는 특정 워크로드에서 전력 효율과 단위비용 경쟁력을 내세우며, 추론 규모가 폭증하는 환경에서 선택지를 넓히는 카드로 부상하고 있습니다.

일부 애널리스트는 "TPU 확대가 GPU 수요를 대체하기보다 전체 AI 컴퓨팅 파이를 키우는 방향"이라고 해석하며, HBM 수요 다변화와 네트워킹 투자 확대로 귀결될 가능성을 제시합니다.

국내 증시에서는 PCB, 패키징, 메모리 관련 밸류체인에 대한 관심이 촉발되었다는 평가가 나옵니다.

기업 실무자를 위한 체크리스트 ✅

- 워크로드 적합성: LLM 학습, 대규모 추론, 추천 시스템, 서빙 지연 요구를 명확히 구분합니다.

- 프레임워크: TensorFlow/JAX 중심인지, PyTorch/XLA 전환 계획이 있는지 점검합니다.

- 데이터 거버넌스: 규제 산업은 온프레미스/전용 리전/하이브리드 조합을 검토합니다.

- TCO 모델링: 전력/냉각/랙 밀도와 네트워크 패브릭 비용을 전체 스택으로 산정합니다.

- 벤더 락인: 멀티가속기 전략과 표준화된 MLOps 파이프라인을 병행합니다.

현재 즉시 가능한 선택지로는 구글 클라우드 TPU를 통한 관리형 리소스 사용이 있으며, 온프레미스형은 파트너십과 공급 일정을 고려한 단계적 도입이 유효합니다.

파일럿 단계에서는 소규모 클러스터로 모델-데이터-파이프라인 적합성을 검증하고, 관측성/프로파일링 도구로 병목을 확인하는 전략이 추천됩니다.

시장 파장과 관전 포인트

메타의 구글 TPU 도입 논의는 ‘탈 엔비디아’ 흐름을 촉진하기보다 멀티벤더 균형을 강화하는 쪽으로 귀결될 가능성이 큽니다.

구글이 외부 공급을 본격화하면, 클라우드 임대와 온프레미스 조달이 병행되는 혼합형 조달 모델이 확산될 전망입니다.

브로드컴을 비롯한 네트워킹·패키징 파트너의 역할이 커지며, HBM과 CXL 생태계도 수요 지형 변화를 맞이할 수 있습니다.

국내 밸류체인에서는 고다층 PCB, 첨단 패키징, 전력·냉각 분야에 기회가 확대될 수 있다는 분석이 나옵니다.

정리: 지금 무엇을 준비할 것인가 🎯

AI 인프라 리더들은 구글 TPU, 엔비디아 GPU, AMD GPU를 아우르는 이기종 가속 전략을 전제로 컴파일-런타임-관측성까지 표준화하는 로드맵을 준비합니다.

워크로드별 TCO와 성능 지표를 객관화하여, 2025~2027년 공급 일정과 예산 사이클에 맞춘 단계적 전환을 설계하는 것이 현실적입니다.

핵심은 ‘선택지의 확대’이며, 구글 TPU의 외부 공급 전환은 기업의 유연한 조달과 비용 효율을 위한 실질적 레버리지로 작동합니다.

관련 보도들은 메타 협상 논의, 브로드컴 생태계 수혜, 국내 밸류체인 관심 증대를 공통적으로 짚으며, 2025년 AI 인프라의 다원화를 전망합니다.

기업과 개발자 모두가 구글 TPU의 도입 경로와 소프트웨어 전환 전략을 점검할 시점입니다.

이미지 출처: 서울경제, 매일경제, 지디넷코리아, 한국경제 보도 이미지입니다.

주: 본 문서는 국내외 주요 매체의 보도를 토대로 정리한 산업 동향 해설이며, 특정 기업이나 제품의 우열을 단정하지 않습니다.