✨ Qwen3 공개, 오픈소스 AI 생태계 지형을 바꾸다

알리바바 클라우드(Qwen 팀)이 22일 새 대규모언어모델 Qwen3-Coder-480B-A35B-Instruct를 발표했습니다. ‘Qwen3’는 최대 4,800억 파라미터*1를 갖춘 Mixture-of-Experts 구조로, 오픈 모델 가운데 최고 수준의 에이전틱 코딩(Agentic Coding) 성능을 제시합니다.

📌 왜 중요한가?

“256K 토큰을 기본 지원하며 100만 토큰까지 확장” – Qwen 팀 공식 블로그

초장문 이해·코드 레포지토리 분석·도구 호출 등 ‘장거리 문맥 처리’가 필요한 영역에서 GPT-4.1, Claude-Sonnet 4와 어깨를 나란히 했다는 점이 화제입니다.

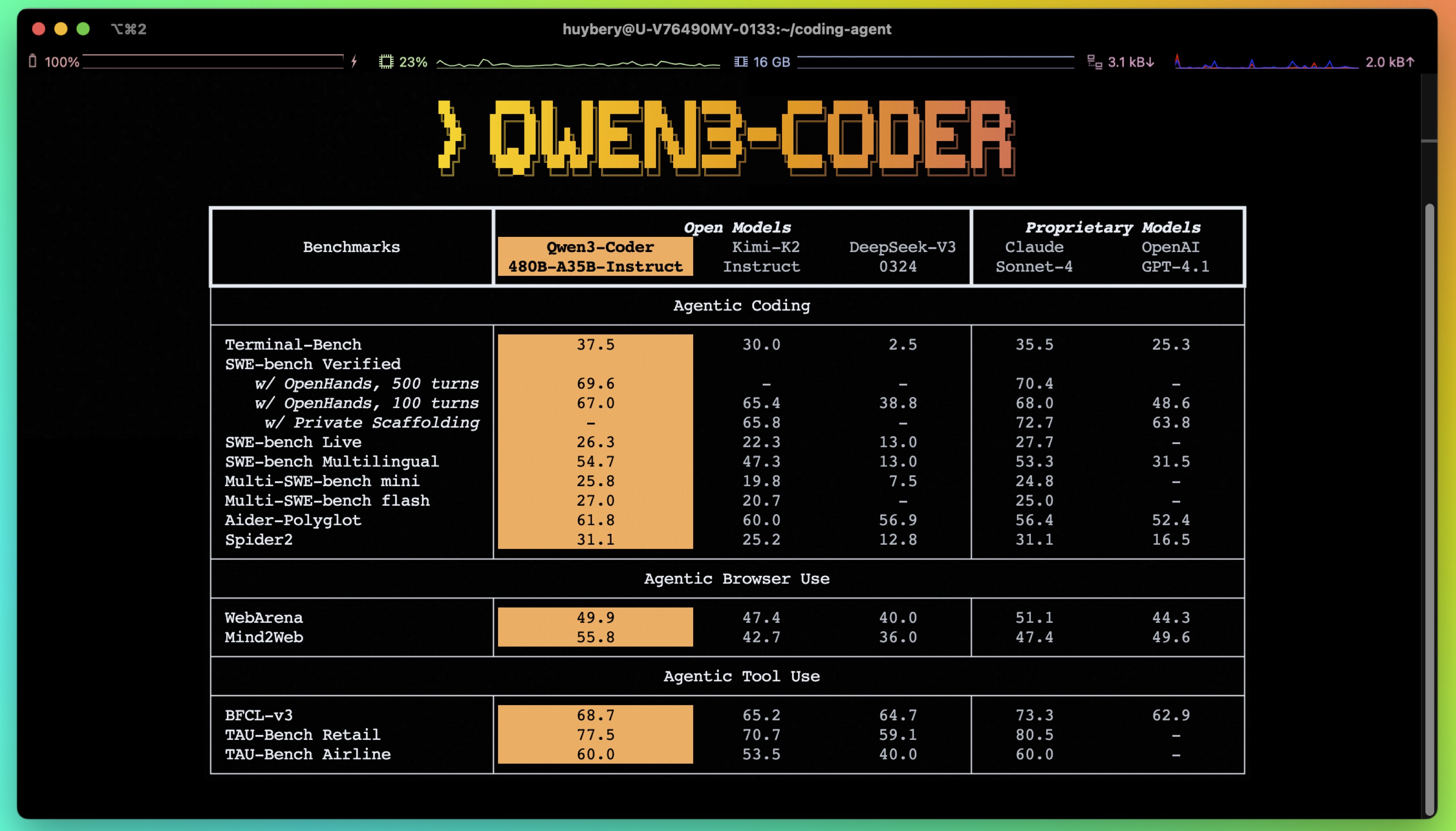

이미지 출처: Qwen 공식 블로그

1️⃣ Qwen3의 핵심 사양

- 모델 크기: 0.5B~480B, 그중 35B 활성 파라미터 MoE

- 문맥 길이: 기본 256K, RoPE Extrapolation으로 1M

- 지원 언어: 영어·중국어·한국어 포함 30여 개

- 라이선스: Apache-2.0 – 상업 이용 가능

2️⃣ 에이전틱 코딩이란?

모델이 함수 호출·브라우저 조작·CLI 실행까지 스스로 계획·완수하는 방식을 뜻합니다. Qwen3-Coder는 자체 function calling protocol을 탑재해 IDE·DevOps 파이프라인과 자연스럽게 연동됩니다. 🤖

3️⃣ 벤치마크 결과

| 벤치마크 | Qwen3-Coder | Claude-Sonnet 4 | GPT-4.1 |

|---|---|---|---|

| AgentCode-Eval | 82.4 | 80.9 | 81.3 |

| HumanEval+ | 79.1 | 77.8 | 78.4 |

| Browser-Tools | 74.6 | 72.3 | 73.0 |

* 수치는 Qwen 공개 리포트 기준

4️⃣ 로컬 실행 가능? 💻

Reddit r/LocalLLaMA·Hacker News 커뮤니티에서는 “4-GPU(80GB H100)로 FP8 추론이 가능했다”는 후기*2가 공유됐습니다. Unsloth 문서 또한 2-bit/4-bit 동적 양자화 예시를 제공해 개인 워크스테이션 수준까지 접근성을 넓혔습니다.

5️⃣ 한국 개발자에게 주는 의미

금융·게임·공공기관 등 국내 레거시 코드가 방대한 조직은, 장문 컨텍스트 지원으로 코드 자동 분석·리팩터링 생산성을 높일 수 있습니다. 특히 AI 풀스택 엔지니어 양성이 가속화될 전망입니다.

6️⃣ 어떻게 써볼까?

- Hugging Face → Qwen/Qwen3-Coder-480B-A35B-Instruct-FP8 모델 카드 다운로드

- CUDA 12↑, vLLM 0.4+ 또는 text-generation-webui 환경 구성

- 예시 프롬프트:

// 기능 명세 JSON 입력 → 코드·테스트·문서 자동 생성

7️⃣ 경쟁 구도와 전망

Llama 3, Mixtral MoE와 달리 Qwen3는 ‘코드 특화’ 전략으로 차별화했습니다. 알리바바 클라우드는 ModelScope Hub, OpenRouter API를 통해 SaaS·PaaS 수익 모델을 확장할 계획입니다.

8️⃣ 책임 있는 활용 가이드

거대 모델 특성상 잘못된 코드 생성 및 보안 취약점 위험이 상존합니다. 기업 사용자는 OWASP AI Top 10 체크리스트와 휴먼 검증 절차를 반드시 병행해야 합니다.

📝 결론

Qwen3는 오픈소스 진영에서 보기 드물게 초거대 파라미터, 긴 문맥, 코드 에이전시 세 요소를 모두 충족했습니다. 이는 “AI 개발 도구가 다시 한번 표준을 끌어올렸다”는 평가로 이어집니다. 한국 IT 생태계 또한 대응 전략 마련이 시급합니다.

*1: 480B-A35B는 480B 파라미터 중 35B가 활동

*2: 실제 요구 사양은 작업 종류·배치 크기에 따라 달라질 수 있습니다.